Mariia Gladkova

Bildverarbeitung und Künstliche Intelligenz

Dynamische simultane Lokalisierung und Kartierung

In den letzten Jahren hat das Gebiet der simultanen Lokalisierung und Kartierung (SLAM) viel Aufmerksamkeit von Seiten der Forschungsgemeinschaft und der Unternehmen auf sich gezogen, die die Entwicklung autonomer Systeme wie Roboter, Autos und Drohnen vorantreiben wollen. Die Kernaufgabe von SLAM besteht in der gemeinsamen Schätzung der Position des Roboters (Lokalisierung) und der Erstellung einer 3D-Karte der Umgebung, in der er sich bewegt (Kartierung). SLAM bietet einen verallgemeinerten modularen Rahmen, der an Systeme mit verschiedenen aktiven und passiven Sensoren wie Kameras, LiDAR, GPS, Radar und anderen angepasst werden kann. Vor allem Kameras sind billige, vielseitige und leichte Sensoren, die reichhaltige und intuitive Informationen in Form von Bildern liefern.

Es gibt viele ausgereifte Computer-Vision-Methoden zur Analyse visueller Daten und zur Extraktion der Ego-Bewegung eines auf einer beweglichen Plattform montierten Kamerasystems. Diese Verfahren beruhen jedoch häufig auf der Annahme einer statischen Umgebung und sind daher in Gegenwart von sich bewegenden Objekten unzuverlässig. Um einen zuverlässigen und robusten Betrieb in realen Szenarien zu erreichen, muss diese Einschränkung systematisch angegangen werden, indem Informationen auf Objektebene in ein SLAM- oder Visual Odometry (VO)-System integriert werden. Zu diesem Zweck können Deep-Learning-Lösungen, die bei verschiedenen Computer-Vision-Aufgaben wie Objekterkennung, -segmentierung und -klassifizierung Spitzenleistungen erbringen, genutzt und weiter an den gewünschten Anwendungsbereich angepasst werden.

Im Rahmen meines Promotionsstudiums möchte ich mich auf die Kombination der Erkennung und Verfolgung von bewegten Objekten mit klassischen VO / SLAM-Methoden konzentrieren. Der Hauptvorteil eines solchen hybriden Systems liegt in der höheren Genauigkeit der Kamera- und Objektposenschätzung sowie in einer konsistenten Rekonstruktion der 3D-Umgebung. Im Vergleich zu bestehenden SLAM-Systemen, die die entsprechenden dynamischen Teile eines Bildes als unecht behandeln, soll es die Bewegung jedes beobachteten Objekts in der Szene korrekt modellieren und zu einem umfassenderen Verständnis der Szene beitragen.

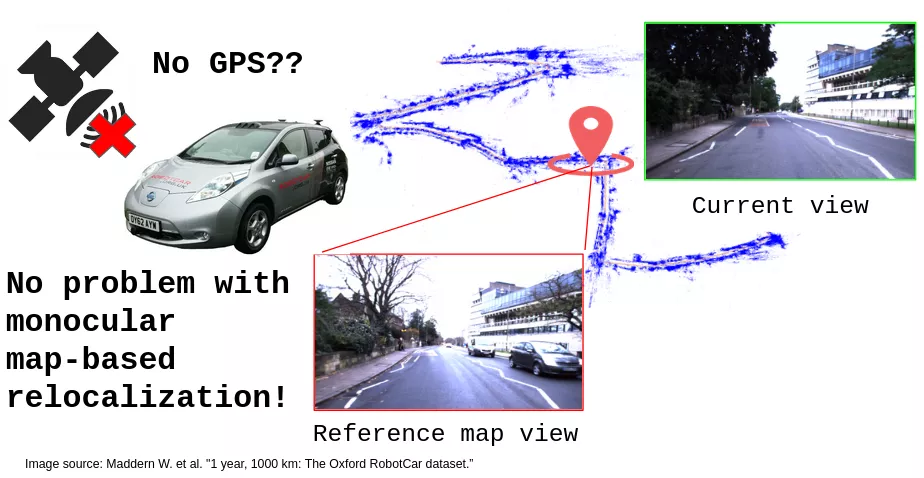

Gladkova M., Wang R., Zeller N., Cremers D. (2021): "Tight Integration of Feature-based Relocalization in Monocular Direct Visual Odometry", Proc. of the IEEE International Conference on Robotics and Automation (ICRA), arXiv:2102.01191

IEEE International Conference on Robotics and Automation (ICRA 2021), 30.05.2021-05.06.2021, Xi'an, China, Päsentation und Konferenzbeitrag